"Teaching thermal physics

is as easy as a song:

You think you make it simpler

when you make it slightly wrong."

(Mark Zemansky)

La Seconda legge della

termodinamica e l’entropia - La prima definizione della seconda legge della

termodinamica era stata formulata nel 1850 dal fisico tedesco Rudolph Clausius,

il quale dimostrò l'impossibilità del passaggio spontaneo del calore da un

corpo freddo a un corpo caldo. Nel 1865 Clausius introdusse il concetto di entropia,

una proprietà termodinamica che prevede che alcuni processi spontanei siano

irreversibili o impossibili. Per definirlo, si basò sulle interazioni tra le

molecole di un gas, descritte da un modello puramente probabilistico delle loro

collisioni. Osservando che il calore tendeva a indebolire il legame tra le

particelle e ad accrescere le distanze medie tra di loro, introducendo questa

nuova grandezza espresse il grado di dispersione delle molecole e quindi l'effetto

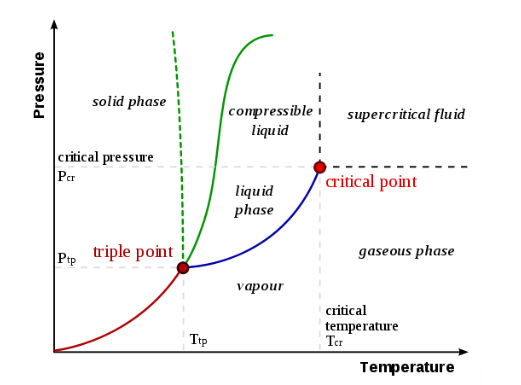

del calore come tendenza ad aumentare il disordine. In questa ottica, è facile

spiegare i passaggi di stato di una sostanza a pressione costante: all’aumento

della temperatura, che è una misura macroscopica del moto delle particelle,

cioè della loro energia cinetica, cresce il loro grado di libertà e i loro

vincoli si allentano. Così un solido diventa un liquido e poi un

gas.

L’entropia S è perciò una proprietà fisica di un sistema termodinamico, correlata al suo grado di ordine. Una variazione dell’ordine è una variazione del numero di modi in cui possono essere disposte le particelle che costituiscono il sistema ed è un fattore determinante nella previsione della direzione in cui avviene una trasformazione spontanea. In generale, ogni processo spontaneo aumenta il grado di disordine del sistema, cioè tutti i sistemi tendono spontaneamente a un aumento del proprio disordine. Più formalmente, possiamo dire che la variazione di entropia ∆S di un sistema isolato durante un processo spontaneo è sempre maggiore o uguale a zero:

L'entropia predice la direzione dei processi spontanei e determina se sono irreversibili o impossibili, anche se obbediscono al requisito fondamentale di conservazione dell'energia come espresso nella prima legge della termodinamica (l'energia totale di un sistema isolato è costante; l'energia può essere trasformata da una forma all'altra, ma non può essere né creata né distrutta).

La seconda legge può essere formulata anche dicendo che l'entropia dei sistemi isolati lasciati all'evoluzione spontanea non può diminuire, in quanto essi giungono sempre ad uno stato di equilibrio termodinamico, dove l'entropia è massima. Se tutti i processi nel sistema sono reversibili, l'entropia è costante e la sua variazione è nulla. Un aumento dell'entropia spiega l'irreversibilità dei processi naturali macroscopici, spesso citata nel concetto di freccia del tempo (le leggi che governano lo scorrere del tempo in meccanica quantistica sono molto più complesse, e, la fisica quantistica ammette anche sovrapposizioni tra processi in cui il tempo può scorrere in avanti o all’indietro, per cui la freccia del tempo termodinamica diventa indefinita: con valori di entropia bassi, il tempo può procedere anche dal futuro al passato).

La prospettiva

dell'entropia statistica fu introdotta nel 1870 dal fisico austriaco Ludwig

Boltzmann, che stabilì un nuovo campo della fisica che forniva il collegamento

descrittivo tra l'osservazione macroscopica della natura e la visione

microscopica basata sul trattamento rigoroso di un grande insieme di microstati

che costituiscono i sistemi termodinamici. Boltzmann definì l'entropia come una

misura del numero di possibili stati microscopici (microstati) di un sistema in

equilibrio termodinamico, coerente con le sue proprietà termodinamiche

macroscopiche, che costituiscono il macrostato del sistema. Un'illustrazione

utile è l'esempio di un campione di gas in un contenitore. I parametri

facilmente misurabili volume, pressione e temperatura del gas descrivono la sua

condizione macroscopica (stato). A livello microscopico, il gas è costituito da

un grande numero di atomi o molecole in movimento libero, che si scontrano

casualmente tra loro e con le pareti del contenitore (microstati). Le collisioni

con le pareti producono la pressione macroscopica del gas, che illustra la

connessione tra fenomeni microscopici e macroscopici.

Un microstato del sistema è una descrizione delle posizioni e dei momenti di tutte le sue particelle. Il gran numero di particelle del gas fornisce un numero infinito di possibili microstati per il campione, ma collettivamente esiste una configurazione media ben definita, che vediamo come macrostato del sistema, in cui ogni singolo contributo di microstato è trascurabile. L'insieme dei microstati comprende una distribuzione statistica di probabilità per ogni microstato, e il gruppo di configurazioni più probabili fornisce lo stato macroscopico. Pertanto, il sistema può essere descritto nel suo insieme solo da alcuni parametri macroscopici, chiamati variabili termodinamiche: l'energia totale E, il volume V, la pressione P, la temperatura T e così via. Tuttavia, questa descrizione è relativamente semplice solo quando il sistema è in uno stato di equilibrio.

L'equilibrio può essere illustrato con un semplice esempio di una goccia di colorante gettata in un bicchiere d'acqua. Il colorante si diffonde in modo complicato, difficile da prevedere con precisione. Tuttavia, dopo che è trascorso un tempo sufficiente, il sistema raggiunge un colore uniforme, uno stato molto più facile da descrivere e spiegare.

Nel 1873 Boltzmann formulò una semplice relazione tra l'entropia e il numero di possibili microstati di un sistema, che indicò con il simbolo W. L'entropia S è proporzionale al logaritmo naturale di questo numero:

dove:

k è la costante di

Boltzmann, il fattore di proporzionalità che mette in relazione l'energia

cinetica media delle particelle in un gas con la sua temperatura termodinamica.

La costante di Boltzmann ha dimensioni di un'energia divisa per la temperatura

assoluta, le stesse dell'entropia;

ln W è il logaritmo naturale

di W, in cui W è la Wahrscheinlichkeit, la probabilità

(termodinamica), cioè il numero di stati in cui il sistema può trovarsi.

Più precisamente, W indica il numero di possibili microstati corrispondenti

allo stato macroscopico di un sistema: il numero di "vie"

(microscopiche, non osservabili) nello stato termodinamico (osservabile) di un

sistema, che si può comprendere assegnando posizioni e momenti differenti alle

varie particelle (atomi o molecole). Poiché W è un numero naturale (1,2, 3...),

l’entropia vale zero o oppure è positiva (ln 1 = 0, ln W ≥ 0).

In pratica, l’equazione

di Boltzmann (riprodotta anche sulla sua lapide funeraria) stabilisce un legame

di proporzionalità tra l’entropia e la quantità di possibili interazioni dei

componenti del sistema (che dipende dal loro numero, dal tipo delle loro

relazioni, dalla loro energia, dalle dimensioni del sistema, ecc.).

L'entropia

di Boltzmann descrive il sistema quando tutti i microstati accessibili sono

ugualmente probabili. È la configurazione corrispondente al massimo di entropia

all'equilibrio. La casualità o il disordine sono massimi, così come la mancanza

di distinzione (o informazione) di ogni microstato.

Disordine e reazioni chimiche - Possiamo affermare che in un sistema composto da oggetti differenti è molto più probabile realizzare uno stato disordinato anziché uno stato ordinato: tale probabilità, inoltre, aumenta con l’aumentare del numero degli oggetti che compongono il sistema. Prendiamo alcuni esempi dalla chimica:

Se, nel corso di una

reazione, una molecola si scinde, dando luogo a molecole più piccole, aumenta

il grado di disordine; nella decomposizione termica (endotermica) del

tetrossido di diazoto (N2O4) si ottengono due molecole di

diossido di azoto (NO2):

Naturalmente avviene il

contrario nelle reazioni in cui molecole più piccole si combinano tra di loro

per dare molecole più grandi, per cui aumenta l’ordine del sistema, ma la

probabilità è contraria allo svolgersi della reazione: nella difficoltosa

sintesi (endotermica) dell’ammoniaca (NH3) a partire da idrogeno (H2)

e azoto (N2) si passa da un sistema con quattro molecole a uno, più

ordinato ma meno probabile, con due:

Se, in una reazione, a

partire da reagenti allo stato solido oppure liquido, si formano prodotti tutti

o in parte allo stato aeriforme, il grado di disordine aumenta: nella

decomposizione termica di una molecola di carbonato di calcio (CaCO3)

allo stato solido, si formano una molecola di ossido di calcio (CaO), solido, e

una molecola di diossido di carbonio (CO2), allo stato gassoso,

dando luogo a un sistema più disordinato:

Il fattore probabilistico

è invece sfavorevole in una reazione in cui il numero di molecole allo stato

gassoso diminuisce, per cui il sistema è più ordinato; ciò avviene ad esempio

nella formazione di ossido di mercurio (HgO), allo stato solido, a partire da

mercurio (Hg), liquido, e ossigeno (O2), gassoso:

Entropia e informazione - In altri termini, come

vedremo, l’entropia dipende dall’informazione ricavabile dal sistema: in teoria

dell'informazione, l'entropia di una variabile casuale è il livello medio di

"informazione", "sorpresa" o "incertezza"

inerente ai possibili esiti della variabile. Il concetto di entropia dell'informazione

fu introdotto da Claude Shannon nel suo articolo del 1948 "A

Mathematical Theory of Communication", ed è indicato anche come entropia

di Shannon. Quando l'entropia è zero bit non c'è alcuna incertezza, nessuna

libertà di scelta, nessuna informazione. Altri valori danno entropie diverse,

tra zero e un bit. L’entropia dell'informazione di un sistema è, dato il

macrostato, la quantità di informazione "mancante" necessaria per

determinare un microstato. Secondo il fisico e statistico Edwin Thompson Jaynes

(1957), l'entropia termodinamica, come spiegato dalla meccanica statistica,

dovrebbe essere vista come un'applicazione della teoria dell'informazione. L'entropia

termodinamica è interpretata come proporzionale alla quantità di ulteriori informazioni

necessarie per definire il dettaglio dello stato microscopico del

sistema, che rimane non comunicato da una descrizione unicamente in termini di

variabili macroscopiche della termodinamica classica, con la costante di

proporzionalità che è proprio la costante di Boltzmann.

Secondo Shannon, l'entropia H di una sorgente X è

riferita all'informazione media contenuta in ogni messaggio emesso. Se la

sorgente X è una variabile aleatoria discreta espressa con base di numerazione b

(2 nel caso di codice binario), N il numero degli eventi, il valore atteso

si riduce ad una media dell'informazione di ogni evento xi

pesata con la propria probabilità P(xi):

il cui dominio è 0 ≤ H(X) ≤ logb N. Matematicamente H può anche essere vista

come un'informazione media, perché quando un certo messaggio si verifica con

probabilità P(xi), si otterrà la quantità di informazioni − logb P(xi) detta

contenuto informativo o autoinformazione.

Se si generalizza

l'entropia termodinamica come fece il chimico americano J. Willard Gibbs, si

vede chiaramente come essa sia simile all'entropia dell'informazione di Claude

Shannon. L’entropia di Gibbs vale:

in cui kb è la

costante di Boltzmann e la seconda parte del membro, adimensionale come il lnW

di Boltzmann, è la sommatoria delle probabilità termodinamiche pi

espresse in percentuale moltiplicata per il loro logaritmo naturale. Questa definizione rimane significativa anche

quando il sistema è lontano dall'equilibrio. Se tutti i microstati sono

equiprobabili, l'entropia termodinamica statistica si riduce alla forma data da

Boltzmann.

È

facile vedere l’equivalenza di forma delle due espressioni (anche se sono

dimensionalmente disuguali: energia/temperatura assoluta contro unità di

informazione). Più i microstati sono coerenti con il macrostato osservato,

maggiore è l'entropia di Shannon e Gibbs. Il concetto si applica sia agli stati

di non equilibrio che agli stati di equilibrio. Ne consegue ciò che affermò

prima di Shannon il chimico Gilbert Lewis: "Guadagno di entropia

significa sempre perdita di informazione, e niente di più". Lo stato

di equilibrio è il macrostato a cui mancano più informazioni sui microstati

sottostanti.

Il demone di Maxwell - Anche quando un

sistema è completamente isolato dalle influenze esterne, il suo microstato è in

continua evoluzione. Ad esempio, le particelle di un gas sono in continuo

movimento, e quindi occupano una posizione diversa in ogni momento; anche i

loro momenti cambiano continuamente mentre si scontrano tra loro o con le

pareti del contenitore. Supponiamo di preparare artificialmente il sistema in

uno stato di equilibrio altamente ordinato. Ad esempio, immaginiamo di dividere

un contenitore con una partizione e posizionare un gas su un lato della

partizione, con il vuoto sull'altro lato. Se rimuoviamo la partizione e

osserviamo il successivo comportamento del gas, troveremo che il suo microstato

si evolve secondo uno schema caotico e imprevedibile, e che in media questi

microstati corrispondono a un macrostato più disordinato di prima. È possibile,

ma estremamente improbabile, che le molecole di gas rimbalzino l'una sull'altra

in modo tale da rimanere in una metà del contenitore. È estremamente probabile

che il gas si diffonda per riempire uniformemente il contenitore, che è il

nuovo macrostato di equilibrio del sistema.

Il demone di Maxwell è un esperimento mentale che ipoteticamente violerebbe la seconda legge della termodinamica. Fu proposto dal grande fisico scozzese James Clerk Maxwell in una lettera al collega Peter Guthrie Tait l'11 dicembre 1867. Apparve di nuovo in una lettera al fisico e chimico John William Strutt nel 1871, prima di essere presentato al pubblico nel libro di Maxwell del 1872 sulla termodinamica intitolato Theory of Heat (Teoria del calore). La sua descrizione dell'esperimento era la seguente:

“... se concepiamo un essere le cui facoltà sono così acute da poter seguire ogni molecola nel suo corso, un tale essere, i cui attributi sono essenzialmente finiti come i nostri, sarebbe in grado di fare ciò che è impossibile per noi. Infatti, abbiamo visto che le molecole in un recipiente pieno d'aria a temperatura uniforme si muovono con velocità per nulla uniformi, sebbene la velocità media di un gran numero di esse, scelte arbitrariamente, sia quasi esattamente uniforme. Supponiamo ora che un tale recipiente sia diviso in due porzioni, A e B, da una divisione in cui vi sia un piccolo foro, e che quell’essere, che può vedere le singole molecole, apra e chiuda questo foro, in modo da permettere solo alle molecole più veloci di passare da A a B, e solo alle molecole più lente di passare da B ad A. Egli così, senza dispendio di lavoro, aumenterà la temperatura di B e abbasserà quella di A, in contraddizione con la seconda legge di termodinamica”.

In altre parole, Maxwell

immaginò un contenitore diviso in due parti, A e B. Entrambe le parti sono

riempite con lo stesso gas a temperature uguali e poste l'una accanto

all'altra. Osservando le molecole su entrambi i lati, un essere immaginario

custodisce una botola tra le due parti. Quando una molecola di A più veloce

della media si avvicina verso la botola, l’essere la apre e la molecola passerà

da A a B. Allo stesso modo, quando una molecola di B più lenta della media si

avvicina verso la botola, l’essere la fa passare da B ad A. La velocità media

delle molecole in B sarà aumentata mentre in A avranno mediamente rallentato.

Poiché la velocità molecolare media corrisponde alla temperatura, la

temperatura diminuisce in A e aumenta in B. Poiché la temperatura cinetica di

un gas dipende dalle velocità delle sue molecole costituenti, le azioni del

demone fanno sì che una camera si riscaldi e l'altra si raffreddi. Ciò

diminuirebbe l'entropia totale dei due gas, senza applicare alcun lavoro,

violando così la seconda legge della termodinamica.

L’essere deve permettere alle molecole di passare in entrambe le direzioni per produrre solo una differenza di temperatura; il passaggio unidirezionale solo di molecole più veloci della media da A a B causerà lo sviluppo di temperatura e pressione più elevate sul lato B.

Nei suoi scritti, Maxwell descrisse l'entità che apre la porta tra le camere come un "essere finito". William Thomson (Lord Kelvin) fu il primo ad usare la parola "demone" per il concetto di Maxwell sulla rivista Nature nel 1874, intendendolo come un δαίμων (daimon) della mitologia greca, un essere soprannaturale a metà strada tra l’umano e il divino, non un essere malevolo nell’accezione cristiana. Fu da allora che l’essere senziente e acuto divenne un demone, quando non un diavoletto, come accade in Italia, travisando il senso originario del nome.

Il demone di Maxwell suscitò un forte dibattito nella filosofia della scienza e nella fisica teorica, che continua fino ai giorni nostri, stimolando il lavoro sulla relazione tra termodinamica e teoria dell'informazione. La maggior parte degli scienziati sostiene, su basi teoriche, che nessun dispositivo pratico può violare la seconda legge in questo modo. Altri ricercatori hanno realizzato esperimenti con forme del demone di Maxwell, anche se in una certa misura differiscono tutti dall'esperimento mentale e nessuno ha dimostrato di violare la seconda legge.

Diversi fisici hanno presentato calcoli che mostrano che, se si fa un'analisi più completa dell'intero sistema, compreso il demone, la seconda legge della termodinamica non sarà effettivamente violata. L'essenza dell'argomento fisico è mostrare che il demone genera più entropia scegliendo e spostando le molecole di quanta ne possa mai eliminare. Ci vorrebbe più lavoro termodinamico per misurare la velocità delle molecole e consentire loro di passare selettivamente attraverso l'apertura tra A e B rispetto alla quantità di energia guadagnata dalla differenza di temperatura.

Nel 1929 l’ungherese Leó Szilárd, e, negli anni ‘50, il francese Léon Brillouin, sottolinearono che un demone di Maxwell nella vita reale avrebbe bisogno di alcuni strumenti per misurare la velocità molecolare e che l'atto di acquisire informazioni richiederebbe un dispendio di energia. Poiché il demone e il gas interagiscono, dobbiamo considerare assieme l'entropia del gas e del demone. Il dispendio di energia da parte del demone provocherà un aumento dell'entropia del demone, che sarà maggiore dell'abbassamento dell'entropia nel gas.

Il fisico dell’IBM Rolf Landauer sollevò un’obiezione a questo argomento. Nel 1961 scoprì il principio che porta il suo nome, secondo cui, in qualsiasi operazione logicamente irreversibile che manipola l'informazione (come la cancellazione di un bit di memoria) l'entropia aumenta e una quantità associata di energia viene dissipata sotto forma di calore. Egli sapeva che alcuni processi di misurazione possono non aumentare l'entropia termodinamica perché sono termodinamicamente reversibili. Suggerì che queste misurazioni "reversibili" potrebbero essere utilizzate per ordinare le molecole, violando la seconda legge. Tuttavia, a causa della connessione tra l'entropia termodinamica e l'entropia dell'informazione, ciò significa anche che la misurazione registrata non deve essere cancellata. In altre parole, per determinare se far passare una molecola, il demone deve acquisire una informazione sullo stato della molecola e scartarla o conservarla. Scartare l’informazione porta all'immediato aumento dell'entropia, ma il demone non può conservarla a tempo indeterminato. Nel 1982, il fisico e teorico dell’informazione Charles Bennett dimostrò che, per quanto ben acuto, alla fine il demone finirà lo spazio di archiviazione delle informazioni e dovrà iniziare a cancellare le informazioni che ha raccolto in precedenza. La cancellazione delle informazioni è un processo termodinamicamente irreversibile che aumenta l'entropia di un sistema. Bennett giunse quindi alla stessa conclusione di Szilard, ma con argomentazioni diverse.

I filosofi della scienza dell’università di Pittsburg, John Earman e John D. Norton hanno sostenuto nel 1998-99 che le spiegazioni di Szilárd e Landauer del demone di Maxwell si basano sull’assunto che la seconda legge della termodinamica non può essere violata dal demone, e derivano ulteriori proprietà del demone da questa ipotesi, inclusa la necessità di consumare energia quando si cancellano informazioni, ecc. Invocare queste proprietà derivate per difendere la seconda legge dall'argomento del demone sarebbe quindi un ragionamento circolare:

“La strategia che dovrebbe essere perseguita dall'abile demone è aspettare uno stato improbabile. Se è consentito un sufficiente tempo di attesa, una violazione spontanea della Seconda Legge è (quasi) sicuro che si verificherà, senza bisogno di un demone per l'elaborazione delle informazioni; a maggior ragione, nulla del costo termodinamico della cancellazione di memoria può impedire la violazione. Forse allora l'obiettivo del gioco non è proteggere la Seconda Legge contro violazioni dirette, ma piuttosto proteggerla da violazioni abbellite, in cui il lavoro viene continuamente estratto da un sistema macroscopico. La nostra idea, per ripeterlo ancora una volta, è che tale protezione dalla violazione può essere offerta solo se il Demone è assimilato a un sistema termico canonico e che la prova non utilizza né beneficia di concetti teorici dell'informazione. E se il Demone non è così assimilato, allora dobbiamo ancora vedere una dimostrazione che deve fallire nei suoi sforzi per violare la Seconda Legge”.

Bennett, nel 2003, riconobbe la validità dell'argomentazione di Earman e Norton, pur sostenendo che il principio di Landauer ha ancora un notevole potere pedagogico ed esplicativo, specialmente nel contesto di altre idee influenti nella fisica del XIX e XX secolo.

Il dibattito sul demone

di Maxwell continua, anche in campi apparentemente lontani dalla termodinamica

e dalla fisica. Ad esempio, nel 2018, un neurologo di Harvard, Ya Wen, ha

pubblicato un articolo chiedendosi se i mitocondri non siano il demone di

Maxwell all'opera in natura. L'idea è che i mitocondri producano energia

dall'elaborazione delle informazioni, o meglio, convertano le informazioni in

energia: “I sistemi viventi utilizzano l'informazione e l'energia per

mantenere uno stato altamente ordinato e un'entropia stabile. È possibile che

il cambiamento dello stato dell'informazione possa influenzare lo stato

dell'energia e viceversa. Lo squilibrio informazione-energia potrebbe essere la

causa fondamentale delle malattie. Se consideriamo che l'informazione e

l'energia sono due aspetti diversi della stessa cosa, allora dovrebbero essere

intercambiabili. Pertanto, lo squilibrio informazione-energia potrebbe essere

corretto. (…) I mitocondri ci forniscono un modello eccellente per

conoscere la relazione tra informazione ed energia. Lo sviluppo della teoria

della conversione informazione-energia aprirà una nuova era nella biologia: la

biologia teorica che richiede il lavoro di squadra di biologi e fisici”.

In effetti, recenti applicazioni della teoria dell’informazione alla medicina e alla biologia hanno riconosciuto il possibile ruolo di strutture di memorizzazione delle informazioni non tradizionali, inclusi lipidi e gradienti ionici, nonché la trasmissione di informazioni tramite flusso molecolare attraverso le membrane cellulari. Rimangono molte sfide affascinanti, inclusa la definizione delle dinamiche di informazione intercellulare degli organismi multicellulari e il ruolo nelle malattie dell'archiviazione disordinata delle informazioni e del loro flusso.