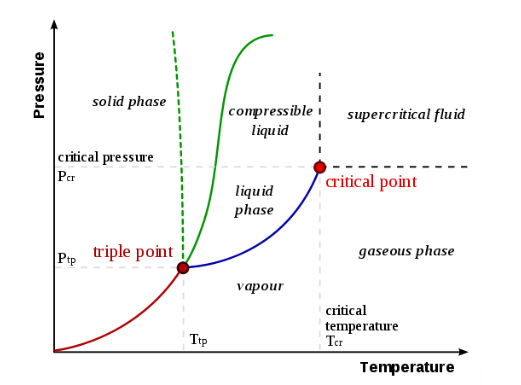

Un diagramma di fase è una rappresentazione grafica degli stati fisici di una sostanza in diverse condizioni, solitamente di temperatura e pressione, ma si possono considerare altre variabili di stato. Un tipico diagramma di fase ha la pressione sull'asse y e la temperatura sull'asse x. Quando attraversiamo le linee o le curve del diagramma di fase, si verifica un cambiamento di fase. Inoltre, due stati della sostanza coesistono in equilibrio sulle linee o curve. Ecco un esempio di diagramma di fase per un sistema monocomponente generico:

Le etichette sul grafico rappresentano gli stati stabili di un sistema in equilibrio. Le linee rappresentano le combinazioni di pressioni e temperature alle quali possono esistere due fasi in equilibrio. In altre parole, queste linee definiscono i punti di cambiamento di fase. La linea rossa divide le fasi solida e gassosa, rappresenta la sublimazione (da solido a gas) e il brinamento (da gas a solido). La linea verde divide le fasi solida e liquida e rappresenta la fusione (da solido a liquido) e la solidificazione (da liquido a solido). Il blu divide le fasi liquida e gassosa, rappresenta l’evaporazione (da liquido a gas) e la condensazione (da gas a liquido). Ci sono anche due punti importanti nel diagramma, il punto triplo e il punto critico. Il punto triplo rappresenta la combinazione di pressione e temperatura che facilita tutte le fasi della materia all'equilibrio. Il punto critico determina l'insieme di particolari condizioni di massima temperatura e massima pressione in corrispondenza delle quali una sostanza può esistere come miscela bifase gas-liquido. Oltre tale punto non si parla più di gas e liquido, bensì di fluido supercritico.

Nella maggior parte delle sostanze, la temperatura e la pressione relative al punto triplo si trovano al di sotto della temperatura e pressione standard e la pressione per il punto critico è al di sopra della pressione standard. Pertanto, alla pressione standard, all'aumentare della temperatura, la maggior parte delle sostanze cambia da solida a liquida in gas, e, alla temperatura standard, all'aumentare della pressione, la maggior parte delle sostanze cambia da gas a liquido a solido.

Normalmente la linea della fase solido/liquido ha una pendenza positiva verso destra (come nel diagramma per l'anidride carbonica). Tuttavia, per altre sostanze, in particolare l'acqua, la linea è inclinata verso sinistra, come mostra il diagramma per l'acqua. Ciò indica che la fase liquida è più densa della fase solida. Questo fenomeno è causato dalla struttura cristallina della fase solida. Nelle forme solide dell'acqua e di alcune altre sostanze, le molecole cristallizzano in un reticolo con uno spazio medio maggiore tra le molecole, risultando così un solido con una densità inferiore rispetto al liquido. A causa di questo fenomeno, si può sciogliere il ghiaccio semplicemente applicando pressione e non aggiungendo calore.

Muoversi all’interno del diagramma di fase fornisce informazioni sulle fasi della sostanza presa in esame. Lo spostamento lungo una linea di temperatura costante rivela le densità relative delle fasi. Quando ci si sposta dalla parte inferiore del diagramma verso l'alto, la densità relativa aumenta. Muoversi lungo una linea di pressione costante rivela le energie relative delle fasi. Quando ci si sposta da sinistra a destra del diagramma, aumentano le energie relative.

I diagrammi di fase e i sistemi che descrivono sono spesso classificati e denominati in base al numero (in latino) di componenti del sistema illustrato nella tabella 1. Chiaramente, all'aumentare del numero di componenti, aumenta anche il numero di sistemi possibili (tabella 2).

Fonte: Massalski (1998)

La tabella mostra che anche se si scelgono solo quattro componenti da un gruppo di, diciamo, 90 elementi, il numero possibile di combinazioni raggiunge milioni, il che ci dice che i diagrammi di fase dei sistemi quaternari sono molto lontani dall'essere determinati, a meno che possano essere calcolati tramite un programma utilizzando stime delle energie libere.

La classificazione e i limiti dei cambiamenti di fase sono descritti dalla regola delle fasi, proposta dal chimico americano J. Willard Gibbs nel 1876 e basata su una rigorosa relazione termodinamica. La regola delle fasi in un sistema con 2 variabili non composizionali (P e T) è comunemente data nella forma P + F = C + 2. La lettera P si riferisce al numero di fasi presenti all'interno del sistema, C è il numero minimo di componenti chimici indipendenti necessari per descrivere la composizione di tutte le fasi del sistema. Il termine F, chiamato varianza, o grado di libertà, descrive il numero minimo di variabili che devono essere fissate per definire una particolare condizione del sistema.

"I diagrammi di fase sono l'inizio della saggezza, non la sua fine". Questa famosa citazione di Sir William Hume-Rothery è una linea guida perfetta per qualsiasi lavoro di scienza e tecnologia dei materiali. I diagrammi di fase sono la mappa migliore per comprendere le condizioni per la formazione o la trasformazione di fase in qualsiasi sistema materiale causata da variazioni di temperatura, composizione, pressione o qualsiasi altra variabile di stato importante. Ecco perché è possibile utilizzare i diagrammi di fase come punto di partenza per la progettazione dei materiali e l'ottimizzazione del processo manipolando la composizione e le variabili di elaborazione per ottenere la microstruttura desiderata. Ciò vale per tutti i tipi di materiali, come leghe, ceramiche, semiconduttori, calcestruzzo, ecc., e per una moltitudine di processi, come fusione, colata, crescita dei cristalli, giunzione, trattamento termico/trasformazione di fase, ossidazione, deposizione di vapore e così via.

La figura 3 mostra il diagramma di fase del ferro puro. Si tratta di un sistema unario, costruito da un singolo componente. Gli assi sono le variabili di stato temperatura T e pressione P, la pressione è mostrata in scala logaritmica per rivelare la regione della fase gassosa insieme alla parte ad alta pressione. Tutte le aree nel diagramma hanno un significato, come si vede dall'esempio seguente. Consideriamo il punto di stato a 1000 K e 103 bar, indicato dal mirino in Fig. 3. Cioè, mettiamo una certa quantità di Fe puro in una scatola chiusa e fissiamo la temperatura e la pressione a questi valori. Ora, gli atomi di Fe possono organizzarsi in varie fasi, come Gas, Liquido, BCC (reticolo cubico compatto), FCC (reticolo cubico a facce centrate) o HCP (reticolo esagonale compatto). Ogni fase ha un valore unico di energia di Gibbs, G (T, P), in quel dato punto di stato. La fase con il valore più basso di energia G di Gibbs è la “vincitrice”; è la fase stabile nella condizione data. In questo caso, è la fase BCC (α). In altre parole, questa è la regione monofase stabile della fase BCC (α) e in qualsiasi punto dello stato in questa regione il valore di energia di Gibbs di qualsiasi fase concorrente è superiore a quello della fase BCC (α). La stessa regola di concorrenza si applica a tutti i punti di stato nell'intero diagramma di fase in Fig. 3 che compone le regioni monofase di Gas, Liquido, BCC (δ), FCC (γ), BCC (α) e HCP. Se si sceglie di utilizzare altre variabili di stato diverse da T e P, altre funzioni termodinamiche invece dell'energia di Gibbs devono essere ridotte al minimo per trovare il campo stabile di ciascuna fase.

La linea di confine tra le regioni BCC (α) e FCC è definita dall'uguaglianza dei valori energetici di Gibbs, G BCC (T, P) = G FCC (T, P). Tale linea non solo rivela la dipendenza dalla pressione della temperatura di trasformazione di fase BCC (α)/FCC, ma forma anche la regione a due fasi BCC (α) + FCC nel diagramma di fase. Tutte queste regioni a due fasi in Fig. 3 sono linee unidimensionali a causa della scelta delle variabili di stato, T e P, per tracciare questo diagramma. La regione trifase BCC (α) + FCC + HCP si verifica solo in un punto di stato unico, 757 K e 105,019 bar nel diagramma di fase. Pertanto, questo è un equilibrio invariante, il punto triplo. I gradi di libertà sono zero ad un equilibrio invariante secondo la regola della fase di Gibbs. Ciò significa che non è possibile modificare alcuna variabile di stato (T o P) senza perdere una fase dall'equilibrio. Al contrario, l'equilibrio a due fasi BCC (α) + FCC in Fig. 3 è monovariante, ha un grado di libertà. Una variabile può essere modificata, almeno in modo infinitesimale, e regolando l'altra lungo la relativa linea T–P si può mantenere l'equilibrio BCC (α) + FCC. Quando si tracciano i diagrammi di fase con la scelta di diverse variabili di stato come assi (es. entalpia anziché temperatura) la topologia delle regioni bifase e trifase può cambiare in modo che non siano più monodimensionali o zero-dimensionali.

La rilevanza geofisica del diagramma di fase del ferro è che aiuta a spiegare perché il nucleo interno della nostra terra è solido. Ciò è caratteristico, perché la temperatura aumenta fino al centro della terra in modo che il nucleo esterno, composto principalmente da una lega ferro-nichel, è liquido. Tuttavia, scendendo più in basso, la lega si solidifica al confine con il nucleo interno, anche se la temperatura continua ad aumentare. Ciò è dovuto al continuo aumento della pressione, che si traduce in un drammatico aumento della temperatura di fusione, mostrato per il Fe puro in Fig.3. La pressione al confine è di circa 330 GPa, o 3,3 × 106 bar, appena fuori dal campo di Fig.3, e la temperatura di fusione della lega ricca di Fe a questa pressione è stimata in 5600 K. L'ulteriore aumento della pressione solidifica la lega.

L'importanza industriale dell'acciaio deriva fondamentalmente da una particolarità del diagramma di fase in Fig. 3, la presenza di due regioni separate di BCC, una ad alta temperatura BCC (δ), e una a bassa temperatura, BCC (α). Normalmente i cristalli FCC più densamente impacchettati dovrebbero essere stabili fino a temperatura ambiente. Tuttavia, i cristalli di ferro BCC meno densamente impacchettati subiscono un ordinamento magnetico, che diminuisce significativamente i valori di G BCC (T), rendendo nuovamente stabile la fase BCC a temperature più basse. Ciò si traduce nel verificarsi della transizione di fase γ/α del ferro, che può essere modificata e adattata mediante l'aggiunta di carbonio e altri elementi di lega nell'acciaio. La corretta progettazione di questa transizione di fase allo stato solido γ/α costituisce la base per il controllo della varietà di microstrutture nell’acciaio, dalla struttura come colata al trattamento termico o alla lavorazione termomeccanica. Senza la transizione FCC (γ)/BCC (α) in Fig. 3 a pressione ambiente l'uomo non potrebbe produrre acciaio.

Tutte le fasi nella Figura 4 hanno la stessa composizione, quella del biossido di silicio, SiO2. Le fasi coesite, quarzo α, quarzo β, tridimite e cristobalite sono fasi solide composte da biossido di silicio; ognuno ha la propria disposizione atomica e un insieme distintivo di proprietà fisiche e chimiche. La forma più comune di quarzo (che si trova nelle sabbie e nei graniti delle spiagge) è il quarzo α. La regione fusa anidra rossa è costituita da biossido di silicio liquido.

Diverse porzioni del sistema di biossido di silicio possono essere esaminate in termini della regola di fase. Nel punto A esiste un'unica fase solida: quarzo α. Sostituendo i valori appropriati nella regola di fase P + F = C + 2 si ottiene 1 + F = 1 + 2, quindi F = 2. Per il punto A (o qualsiasi punto in cui una sola fase è stabile) il sistema è bivariante: cioè esistono due gradi di libertà. Pertanto, le due variabili (pressione e temperatura) possono essere modificate indipendentemente e lo stesso insieme di fase continua ad esistere.

Il punto B si trova sulla curva di confine tra i campi di stabilità del quarzo α e del quarzo β. In tutti i punti lungo questa curva, queste due fasi coesistono. Sostituendo i valori nella regola di fase (2 + F = 1 + 2) si otterrà una varianza pari a 1. Ciò indica che una variabile indipendente può essere modificata in modo tale da mantenere la stessa coppia di fasi. Una seconda variabile deve essere modificata per conformarsi alla prima in modo che l'assemblaggio di fase rimanga sul confine tra quarzo α e β. Lo stesso risultato vale per le altre curve limite in questo sistema.

Il punto C si trova in un punto triplo, condizione in cui si intersecano tre campi di stabilità. La regola di fase (3 + F = 1 + 2) indica che la varianza è 0. Il punto C è quindi un punto invariante; una variazione di pressione o di temperatura comporta la perdita di una o più fasi. La regola delle fasi rivela inoltre che non più di tre fasi possono coesistere stabilmente in un sistema a un componente perché fasi aggiuntive porterebbero a una varianza negativa.

Tutti gli altri diagrammi di fase P-T unari o monocomponenti possono essere compresi seguendo gli esempi forniti. Le regole e la topologia risultanti sono identiche se il componente è un elemento o una sostanza pura, definita come un composto che non può cambiare composizione.

Esistono molti altri composti stechiometrici solidi con un intervallo di soluzione solida trascurabile o una deviazione stechiometrica trascurabile, che formano una sostanza solida pura. Alla fusione, tuttavia, la composizione spesso non viene mantenuta. È ad esempio il caso del carburo di silicio, SiC, un importante composto semiconduttore e anche un importante materiale ceramico. Riscaldando SiC a 1 bar sopra 2830 °C si ottiene una fase liquida ricca di silicio con solo il 19% di C e in aggiunta una certa quantità di grafite, bilanciando così l'originale 50% di SiC. Cioè, il cristallo di SiC monofase si decompone in un liquido e grafite, con un processo chiamato di fusione incongruente. Questo è un equilibrio a tre fasi, non una semplice fusione a due fasi. Nel diagramma di fase P-T del SiC a 1 bar la regione monofase del SiC solido termina a 2830°C, oltre uno spazio vuoto si forma la regione bifase liquido + grafite. Il calcolo mostra che è necessaria una temperatura di 3600°C (e una pressione di almeno 8 bar per evitare l'evaporazione) per ottenere "SiC" liquido monofase con 50% di C. Questo ampio gap di 790 K, liquido + grafite, nel "diagramma di fase P-T di SiC" si verifica perché, tecnicamente parlando, è una sezione nel diagramma di fase P-T-x del sistema binario Si-C a 50% costante di C.

Pertanto, il composto SiC non può essere ben rappresentato da un diagramma di fase P-T unario, a differenza del composto H2O. Affinché la topologia semplice di Fig. 1, osservata per qualsiasi elemento, prevalga anche per un composto, è necessario che questo composto esista in tutte le fasi in tutte le condizioni (in tutti i punti di stato) come monofase stabile, realizzando tutte le transizioni di fase congruenti. In caso contrario, la topologia del diagramma di fase P-T sarà più complessa. L'importante distinzione tra proprietà e diagramma di fase, tuttavia, è generalmente valida e deve essere tenuta presente anche per sistemi multicomponente.