La vita è spesso definita in base a un elenco di proprietà

che distinguono i sistemi viventi da quelli non viventi. Sebbene vi sia una

certa sovrapposizione, questi elenchi sono spesso diversi, a seconda degli

interessi degli autori. Edward Trifonov ha raccolto nel 2011 più di 120 definizioni di vita, cercando un

denominatore comune, ma questo approccio non è sembrato scientifico a molti:

ogni tentativo di definizione è legato a una teoria da cui deriva il suo

significato e non può essere ottenuto da pratiche combinatorie.

Gli esseri viventi condividono una serie di proprietà che non sono presenti contemporaneamente nella materia inanimata, sebbene si possano trovare esempi di materia che esibisce l'una o l’altra, ma mai insieme. Le entità viventi metabolizzano, cioè ricavano energia chimica dalla degradazione di sostanze nutritive ricche di energia, dall’ambiente o dall’energia solare; convertono le molecole nutritive nei precursori di base delle macromolecole cellulari; utilizzano questi precursori per formare altre sostanze organiche con diversa natura e funzioni; formano e degradano biomolecole necessarie a funzioni specializzate delle cellule.

Inoltre,

crescono, si riproducono, interagiscono con il loro ambiente, hanno strutture

organizzate complesse, variabilità ereditabile e hanno discendenze che possono

evolversi nel tempo, producendo strutture funzionali nuove che forniscono una

maggiore capacità di adattamento in ambienti mutevoli. La riproduzione

coinvolge non solo la replicazione degli acidi nucleici che trasportano

l'informazione genetica, ma anche la costruzione epigenetica dell'organismo

attraverso meccanismi di metilazione di acidi nucleici e proteine che

non coinvolgono il genotipo.

Ciò che è vivo ha strutture organizzate e complesse che

svolgono queste funzioni, oltre a percepire e rispondere agli stati interni e

all'ambiente esterno e impegnarsi nel movimento all'interno di quell'ambiente.

Va ricordato che i fenomeni evolutivi sono un aspetto inestricabile dei sistemi

viventi; ogni tentativo di definire la vita in assenza di questa prospettiva

diacronica è vano.

La scuola inglese

Il dibattito moderno sul rapporto tra materia e vita si sviluppò

durante il periodo in cui i biochimici stavano cercando di definire il loro

campo come una disciplina separata dalla chimica o dalla fisiologia, intorno al

1930.

Lo scienziato e divulgatore britannico John B. S. Haldane

in The Sciences and Philosophy (1929) si

oppose alla riduzione dei fenomeni biologici a spiegazioni meccanicistiche,

poiché vedeva la struttura degli organismi biologici e la loro azione diversi

da ciò che si vedeva nei sistemi fisici. Le leggi della chimica e della fisica

non erano abbastanza solide per spiegare la biologia. “È la vita che stiamo

studiando in biologia, e non fenomeni che possono essere rappresentati da

concezioni causali della fisica e della chimica”.

Il biologo sperimentale e statistico medico Lancelot

Hogben, nel libro The Nature of Living Matter (1930), lamentava il

disinteresse di molti biologi del suo tempo per il ruolo dell’ambiente nello

sviluppo degli organismi e sosteneva una visione riduzionista. Per Hogben, la

natura della scienza è che le sue risposte sono sempre incomplete ed essa non

ha gli stessi obiettivi della filosofia. Hogben non vedeva la necessità di

abbandonare la metodologia riduzionista che la biochimica stava

sviluppando.

Per Joseph H. Woodger (Biological Principles: A Critical

Study, 1929) la risoluzione doveva giungere dal

riconoscimento dell'importanza primaria dell'organizzazione biologica e dei

suoi livelli: “per cellula quindi intendo un certo tipo di organizzazione

biologica, non un'entità concreta”. Woodger esortava ad abbandonare l'uso

della parola "vita" nel discorso scientifico sulla base del fatto che

"organismo vivente" era ciò che doveva essere spiegato. Per Woodger

la domanda sul come è nata la vita è al di fuori della scienza.

Forse il luogo in cui il problema della natura della vita

venne affrontato con maggiore insistenza fu il Dipartimento di Biochimica

dell'Università di Cambridge. Durante la prima metà del ventesimo secolo, sotto

la guida del biochimico Sir Frederick Gowland Hopkins, il dipartimento stabilì

gran parte del quadro concettuale e della metodologia, oltre a formare molti

dei più noti esponenti del settore. Hopkins credeva che, sebbene gli esseri

viventi non disubbidiscano a nessuna legge fisica o chimica, essi le

sostanziano in modi che richiedono la comprensione dei fenomeni biologici, dei

vincoli e dell'organizzazione funzionale.

Nel suo importante discorso alla British Association for

the Advancement of Science tenuto nel 1913, Hopkins respinse sia il

riduzionismo dei chimici organici che cercavano di dedurre in vitro ciò

che doveva accadere in vivo, sia il cripto-vitalismo di molti fisiologi

che osservavano il protoplasma delle cellule viventi come vivo in sé stesso e

irriducibile all'analisi chimica. Ciò che Hopkins offriva invece era una

visione della cellula come una macchina chimica, obbediente alle leggi della

termodinamica e della chimica fisica in generale, ma con strutture e funzioni

molecolari organizzate. La cellula vivente “non è un grumo di materia

composto da un gruppo di molecole simili, ma un sistema altamente

differenziato: la cellula, nella moderna concezione della chimica fisica, è un

sistema di fasi coesistenti di diversa natura”. Capire come si era

realizzata l'organizzazione era tanto importante quanto sapere come si erano

verificate le reazioni chimiche. Per Hopkins la vita è “una proprietà della

cellula nel suo insieme, perché dipende dall'organizzazione dei processi”.

Hopkins era influenzato dalla filosofia di Alfred North Whitehead sviluppata in Process and reality (1929), che

sosteneva che la realtà consiste di processi piuttosto che di oggetti

materiali, e che i processi sono meglio definiti dalle loro relazioni con altri

processi, rifiutando così la teoria secondo cui la realtà è fondamentalmente

costituita da pezzi di materia che esistono indipendentemente l'uno dall'altro.

Un membro del dipartimento di Cambridge, il biochimico,

storico della scienza e più tardi grande sinologo Joseph Needham, si impegnò

attivamente nel divulgare le idee di Hopkins nella comunità intellettuale

scrivendo della base filosofica della biochimica in Science, Religion and

Reality (1925). Needham seguì Hopkins nell'affermare che la questione

cruciale non era più il rapporto tra sostanza vivente e non vivente, ma anche

tra mente e corpo, e la biochimica doveva affidare alla filosofia e alle allora

nascenti neuroscienze quest'ultima questione, affinché potesse concentrarsi sul

conoscere la materia vivente. Un altro membro del dipartimento di biochimica,

Norman Pirie, nel 1937 argomentò che essa non poteva essere adeguatamente definita

da un elenco di qualità e nemmeno di processi, poiché la vita "non può

essere definita in termini di una variabile". Per il programma del

gruppo di Hopkins c’era la sfida di capire come leggi fisiche e chimiche

piuttosto semplici possano produrre la complessità dei sistemi viventi.

Durante gli anni '30 un gruppo informale, noto come Biotheoretical

Gathering, si riuniva a Cambridge e comprendeva diversi membri del

dipartimento di biochimica e un certo numero di altri scienziati di Cambridge e

filosofi. Questo gruppo aveva l'obiettivo di costruire una biologia teorica e

filosofica transdisciplinare, che aiutasse a gettare le basi per l’affermazione

della biologia molecolare. Il programma di ricerca di Hopkins era ben

consolidato e fu collegato al lavoro del Biotheoretical Gathering,

influenzando John B. S. Haldane, che diede importanti contributi alla teoria

degli enzimi e alla creazione della moderna sintesi evolutiva, il neodarwinismo. Haldane avrebbe svolto un ruolo

importante nello spostare la preoccupazione dalla natura della vita alla sua

origine come soggetto di studio scientifico. Haldane sospettava, insieme a

Pirie, che una definizione di vita pienamente soddisfacente fosse impossibile,

ma affermava che la definizione materiale era un obiettivo ragionevole per la

scienza. Vedeva la vita come “un modello di processi chimici. Questo modello

ha proprietà speciali. Genera uno schema simile, come fa una fiamma, ma si

regola come una fiamma non fa”. L'uso della metafora della fiamma per

l'attività metabolica cellulare implicava un processo di non equilibrio in un

sistema aperto in grado di riprodursi, ma anche, al limite della metafora, di

autoregolazione. In ciò, Haldane rifletteva la preoccupazione di capire come la

materia e le leggi fisiche potessero portare a fenomeni biologici.

Cos'è la vita? di

Schrödinger

Nel 1943 il grande fisico Erwin Schrödinger (sì, quello dell'equazione della funzione d'onda e del paradosso del gatto) tenne una serie

di conferenze al Dublin Institute for Advanced Studies, che furono

pubblicate come What is Life? nel 1944. Questo piccolo libro ebbe un

grande impatto sullo sviluppo della biologia del ventesimo secolo, specialmente

sui fondatori della biologia molecolare. Schrödinger si chiedeva come fosse

possibile che ci fosse un ordine duraturo nelle molecole responsabile

dell'ereditarietà, quando era ben noto che gli insiemi statistici di molecole

diventavano rapidamente disordinati (con un aumento dell'entropia come previsto

dalla seconda legge della termodinamica). Il problema dell'ereditarietà fu

quindi riformulato a livello molecolare con la domanda “Come l'ordine può

dar luogo all'ordine?” L'altro argomento principale che interessava

Schrödinger era la termodinamica degli esseri viventi in generale, ovvero “Come

possono generare ordine dal disordine attraverso il loro metabolismo?”

Fu la

risposta alla prima domanda che catturò l'attenzione dei fondatori della nuova

biologia. Schrödinger sosteneva che il materiale molecolare doveva essere un

solido "aperiodico" che aveva incorporato nella sua struttura un

"codice in miniatura". Le idee di “'cristallo aperiodico” e di

“codice” non erano in realtà originali (il DNA era stato scoperto dallo

svizzero Friedrich Miescher nel 1869, ma il suo ruolo nella riproduzione e

la forma elicoidale erano ancora sconosciuti), ma insistevano sull'ipotesi di

una logica molecolare della vita. Ciò voleva dire che la struttura degli atomi

che comprendono la molecola dell’eredità non possedeva un singolo ordine

periodico ripetitivo, ma avrebbe avuto piuttosto un ordine di livello superiore

a causa della struttura delle sue subunità molecolari; era questo ordine di

livello superiore, ma aperiodico, che avrebbe contenuto le informazioni

codificate dell'ereditarietà.

Nel 1952 l'esperimento di Alfred D. Hershey e Martha

Chase provò definitivamente che il materiale genetico è costituito

da DNA e non da proteine. Con la scoperta nel 1953 della struttura a

doppia elica del DNA da parte di James D. Watson e Francis H.C. Crick, la

specificità biologica fu ricondotta alla sequenza definita e unica dei nucleotidi

che trasporta quella che da quel momento viene chiamata l'informazione

genetica. 'Specificità' e 'informazione' vennero a coincidere e nel 1958 Crick

affermava che "la specificità di un pezzo di acido nucleico è espressa

solamente dalla sequenza delle sue basi, e [che tale] sequenza è un

codice (semplice) per la sequenza di amminoacidi di una particolare

proteina"; quindi "informazione significa determinazione

precisa della sequenza, sia delle basi nell'acido nucleico sia dei residui

amminoacidici della proteina". Nello stesso anno, Crick definiva

il “dogma centrale” della biologia molecolare, secondo cui il flusso

dell'informazione genetica è monodirezionale: parte dagli acidi nucleici per

arrivare alle proteine, senza considerare un percorso inverso.

La delucidazione della struttura del DNA e la maggior

comprensione della genetica molecolare eclissò l'altra parte dell'argomentazione

di Schrödinger, cioè che l'aspetto più importante del metabolismo è che esso

rappresenta il modo della cellula di affrontare l'entropia che non può fare a

meno di produrre mentre costruisce il suo ordine interno, ciò che Schrödinger

definì "negentropia". Egli notò che la cellula deve mantenersi

in uno stato lontano dall'equilibrio poiché l'equilibrio termodinamico è la

definizione stessa di morte. Creando ordine e organizzazione all'interno di un

sistema vivente (cellule, organismi o ecosistemi), le attività metaboliche

devono produrre un maggiore disordine nell'ambiente, in modo che la seconda

legge non venga violata. Legò le due nozioni, di ordine dall'ordine e ordine

dal disordine, affermando che "il dono sorprendente di un organismo di

concentrare un “flusso di ordine” verso se stesso e sfuggire così al

decadimento nel caos atomico - di “bere ordine” da un ambiente adatto — sembra

essere collegato alla presenza di “solidi aperiodici”, le molecole

cromosomiche, che rappresentano senza dubbio il più alto grado di associazione

atomica ben ordinata che conosciamo (molto più alto del normale cristallo

periodico) in virtù del ruolo individuale che ogni atomo e ogni radicale sta

giocando”.

L’ordine che crea l’ordine

L'impatto del piccolo volume di Schrödinger su una

generazione di fisici e chimici che furono attratti dalla biologia e che

fondarono la biologia molecolare fu duraturo. La conoscenza delle basi

proteiche e degli acidi nucleici dei sistemi viventi continua ad essere

ottenuta a un ritmo accelerato, con il sequenziamento del genoma umano come

punto di riferimento importante lungo il percorso che ha portato all’ingegneria

genetica (tecnologia del DNA ricombinante).

In Il gene egoista (1976, 1989), l’etologo, biologo

e divulgatore Richard Dawkins identificò nel gene, anziché nell'organismo

individuale, il soggetto principale della selezione naturale che conduce il

processo evolutivo. Dawkins, affermava che: “L'unità fondamentale della

selezione, e quindi dell'egoismo, non è né la specie né il gruppo e neppure, in

senso stretto, l'individuo, ma il gene, l'unità dell'ereditarietà”. Nel

descrivere i geni come egoisti, l'autore non intendeva (come è

inequivocabilmente dichiarato nel libro) implicare che sono guidati da motivi o

volontà, ma semplicemente che i loro effetti possono essere accuratamente

descritti come se lo fossero. Il mondo è diviso in replicatori, molecole

stabili che, a differenza delle altre, hanno la capacità di replicarsi, che sono visti come il livello fondamentale di azione per la

selezione naturale, e interattori, le molecole e le strutture codificate

dai replicatori. Questi replicatori si diffusero nel “brodo primordiale”, popolando il mare. Il

processo di replicazione non è però perfettamente fedele, in alcuni casi si

creano delle copie sbagliate. L'errore di copiatura ha giocato un ruolo

fondamentale nell'evoluzione della vita, poiché permise la propagazione di

molecole diverse tra loro, alcune delle quali riuscivano a replicarsi meglio.

La competizione fra queste molecole e le avversità ambientali selezionavano i

replicatori più adatti, i quali perfezionarono le loro tecniche di

propagazione. Alcuni di essi, ipotizzava Dawkins, potrebbero essersi evoluti in

modo da potersi "nutrire" di altri replicatori, altri ancora

potrebbero aver costruito una sorta di scudo di protezione dagli agenti

esterni, dando vita alle prime forme di cellule primordiali. I replicatori di

oggi sono i geni all'interno degli organismi viventi. In effetti, Dawkins

relegava gli organismi allo stato di veicoli genici, o macchine di sopravvivenza.

Le idee di Dawkins suscitarono una reazione a quella che

venne percepita come un'eccessiva enfasi sulla replicazione degli acidi

nucleici. In particolare, i teorici dei sistemi di sviluppo hanno sostenuto un

pluralismo causale nella biologia dello sviluppo e dell'evoluzione. La

posizione di Dawkins fu fortemente contestata dagli americani Niles Eldredge,

paleontologo, e Stephen Jay Gould, biologo, paleontologo e storico della

scienza, estensori della teoria degli equilibri punteggiati. Tale teoria

sostiene che i cambiamenti evolutivi avvengono in periodi di tempo

relativamente brevi (su scala geologica) sotto l'impulso di forze selettive

ambientali; questi periodi di variazione evolutiva sarebbero intervallati da

lunghi periodi di stabilità. L'accesa e prolungata polemica di Gould contro

Dawkins nasceva dalla sua opposizione al determinismo sotteso al suo pensiero,

a favore dell'indeterminismo che, secondo Gould sta alla base della maggior

parte dei processi biologici innovativi. Nella visione di Gould, come peraltro

in quella già del francese Jacques Monod e di tutti i biologi

evoluzionisti, il caso (serie di cause sconnesse o causalità intricata) produce

il nuovo, mentre la necessità, attraverso la selezione naturale che opera in

base a causalità lineare, conserva l'adatto ed elimina l'inadatto.

Un altro oppositore di Dawkins fu il genetista Richard

Lewontin, il quale sosteneva che, mentre il darwinismo tradizionale ha

descritto l'organismo come soggetto passivo di influenze ambientali, sarebbe

più corretto descrivere l'organismo come costruttore attivo del suo ambiente.

Le nicchie ecologiche non sono ricettacoli

precostituiti in cui gli organismi vengono inseriti, ma sono definite e create

dagli organismi stessi. Il rapporto organismo-ambiente è dunque reciproco e

dialettico. Lewontin è stato un critico tenace di alcuni temi del

neodarwinismo; in particolare ha criticato coloro che, come anche Dawkins, tentavano

di spiegare i comportamenti e le strutture sociali degli animali in termini di

vantaggio o di strategia evoluzionistici; questo indirizzo di studio, secondo

Lewontin, può essere considerato come una forma di determinismo genetico.

Il disordine che crea l’ordine

Meno noto è l'oltre mezzo secolo di lavoro ispirato

dall'altro pilastro del discorso di Schrödinger, cioè come gli organismi

ottengono ordine dal disordine attraverso la termodinamica di sistemi aperti

lontani dall'equilibrio. Tra i primi studiosi di tale termodinamica di non

equilibrio spicca il chimico e fisico Ilya Prigogine, noto soprattutto per la

sua definizione di strutture dissipative e il loro ruolo nei sistemi

termodinamici lontani dall'equilibrio, una scoperta che gli è valsa il Premio

Nobel per la Chimica nel 1977. Una struttura dissipativa è un sistema

termodinamicamente aperto che opera in uno stato lontano dall'equilibrio

termodinamico, scambiando con l'ambiente energia, materia e/o entropia. I

sistemi dissipativi sono caratterizzati dalla formazione spontanea di

anisotropia, ossia di strutture ordinate e complesse, a volte caotiche. Questi

sistemi, quando attraversati da flussi crescenti di energia, materia e

informazione, possono anche evolvere e, passando attraverso fasi di

instabilità, aumentare la complessità della propria struttura (ovvero l'ordine)

diminuendo la propria entropia. In sintesi, Ilya Prigogine ha scoperto che l'importazione e

la dissipazione di energia nei sistemi chimici potrebbe risultare

nell'emergenza di nuove strutture (quindi strutture dissipative) dovute

all'auto-organizzazione interna. In natura esistono organismi viventi in grado

di auto-organizzarsi diminuendo la propria entropia a discapito dell'ambiente,

vincolati a un maggior o minor disordine entropico. A partire da queste

considerazioni, Prigogine e altri studiosi hanno cominciato a gettare un ponte

tra la fisica, la chimica, l'ecologia e le scienze sociali, per studiare tali

settori non separatamente, ma come sistemi tra loro interagenti. Per questa

ragione Prigogine è considerato uno dei pionieri della scienza della

complessità.

Il biofisico americano Harold Morowitz affrontò

esplicitamente la questione del flusso energetico e della produzione

dell'organizzazione biologica. L'ordine interno può essere prodotto da

gradienti di flussi di materia/energia attraverso i sistemi viventi. Le

strutture così prodotte aiutano non solo ad assorbire più energia attraverso il

sistema, ad allungare il suo tempo di ritenzione nel sistema, ma anche a

dissipare l'energia degradata nell'ambiente, pagando così il "debito di

entropia" di Schrödinger. I sistemi viventi sono quindi visti come un

esempio di un fenomeno più generale di strutture dissipative. “Una struttura

dissipativa si rinnova continuamente e mantiene un particolare regime dinamico,

una struttura spazio-temporale globalmente stabile”. Naturalmente, se si

verificano fenomeni di auto-organizzazione dipende dalle effettive condizioni

specifiche (iniziali e al limite) nonché dalle relazioni tra i componenti.

Considerare la cellula come una “struttura dissipativa”

termodinamica non era una riduzione della cellula alla fisica, come sottolineò

il fisico, biologo molecolare e storico della scienza britannico John Desmond

Bernal, ma piuttosto implicava una fisica della "complessità

organizzata" (in contrasto con l'ordine semplice o "complessità

disorganizzata"). Lo sviluppo di questa “nuova” fisica dei sistemi aperti

e delle strutture dissipative che sorgono in essi fu il compimento dello

sviluppo che Schrödinger aveva previsto. Le strutture dissipative nei sistemi

fisici, chimici e biologici sono fenomeni spiegati dalla termodinamica del non

equilibrio. I modelli spazio-temporali emergenti e auto-organizzati sono visti

anche nei sistemi biologici.

In effetti, i fenomeni di auto-organizzazione pervadono la

biologia. Tali fenomeni sono visti non solo nelle cellule e negli organismi, ma

anche negli ecosistemi, il che rafforza l'idea che sia necessaria una

prospettiva sistemica più ampia come parte della nuova fisica. Importanti per

tali fenomeni sono le dinamiche delle interazioni non lineari (dove le risposte

di un sistema possono essere molto più grandi dello stimolo) e dei cicli

autocatalitici (sequenze di reazioni chiuse su sé stesse e in cui è presente

una maggiore quantità di uno o più materiali di partenza). realizzati

attraverso i processi. Dato che i catalizzatori nei sistemi biologici sono

codificati nei geni del DNA, un punto da cui iniziare a definire la vita è

considerare i sistemi viventi come entità cicliche informate e autocatalitiche

che si sviluppano ed evolvono sotto i doppi dettami della seconda legge della

termodinamica e della selezione. Un tale approccio collega in modo non

riduttivo i fenomeni dei sistemi viventi con le leggi fondamentali della fisica

e della chimica. Il biologo americano Robert Rosen sosteneva che la complessità

non è la vita in sé, ma ciò che definiva "l'habitat della vita": “L'organizzazione

coinvolge intrinsecamente le funzioni e le loro interrelazioni”.

Origine (emergenza) della vita

Uno dei fenomeni emergenti più importanti è quello

dell'origine della vita. Il biologo cellulare Franklin Harold lo ha definito

come il problema scientifico più importante che oggi abbiamo di fronte. Il

filosofo della scienza britannico Michael Ruse ha affermato che è essenziale

inquadrare la ricerca sull'origine della vita nel darwinismo, poiché è una

condizione necessaria per una definizione della vita scientificamente e

filosoficamente adeguata, mentre Robert Rosen ha sostenuto che la ragione

per cui alla domanda "cos'è la vita?" è così difficile rispondere è

che vogliamo in realtà sapere molto di più di quello che è, vogliamo

sapere perché è: "Ci stiamo davvero chiedendo, in termini

fisici, perché uno specifico sistema materiale è un organismo e non

qualcos'altro". Per rispondere a questa domanda del perché dobbiamo

capire come potrebbe essere sorta la vita, continuando un filone di ricerca che

ha attraversato gran parte del ventesimo secolo.

Durante gli anni '20 del Novecento, Alexander Oparin e John

B. S. Haldane hanno proposto indipendentemente le prime ipotesi moderne su come

la vita potrebbe aver avuto origine sulla Terra. I presupposti chiave erano che

le condizioni geofisiche sulla terra primitiva erano molto diverse da quelle

presenti, e, cosa più importante, che non ci sarebbe stato ossigeno molecolare

nell'atmosfera (l'ossigeno si è sviluppato molto più tardi con la comparsa di

organismi fotosintetici). In questa atmosfera chimicamente riducente si sarebbe

sviluppato un “brodo” di molecole organiche sempre più complesse, da cui

potrebbero essere nati i precursori dei sistemi viventi. In effetti, questo tipo

di approccio può essere definito una visione incentrata sul metabolismo.

Un momento importante fu la dimostrazione che alcuni

amminoacidi potrebbero essere stati prodotti dall'azione di una scarica

elettrica attraverso una miscela di gas ritenuti presenti nell'atmosfera

primitiva. Si tratta del famoso esperimento di Stanley Miller e Harold Urey del

1953, che fu tuttavia contestato perché non dava conto del fatto che gli

amminoacidi trovati costituivano una miscela di enantiomeri levogiri e destrogiri,

mentre quelli delle proteine

viventi sono solamente levogiri. L’esperienza fu in ogni caso considerata un

altro possibile punto di partenza per lo sviluppo di sostanze costitutive degli

esseri viventi, ovvero le proteine, che sono polimeri di amminoacidi formate in

condizioni di alta temperatura. Questa visione di “prima le proteine” suggeriva

che la chimica che porta alla vita potrebbe essersi verificata in un ambiente

isolato, con una debole attività catalitica, che avrebbe facilitato la produzione

degli altri componenti molecolari necessari.

Con la comprensione della struttura del DNA, l'attenzione

si è spostata verso gli acidi nucleici, che potrebbero fungere da modelli per

la propria replicazione. Sebbene Dawkins pensasse che un acido nucleico,

formato per caso, sarebbe stato l'inizio della vita poiché si sarebbe

"auto replicato", molti approcci per arrivare agli acidi nucleici

implicano un ruolo per certe molecole abiotiche minerali di contribuire a

formare strutture che fungono da modelli di ordinamento e persino come

catalizzatori per la loro formazione.

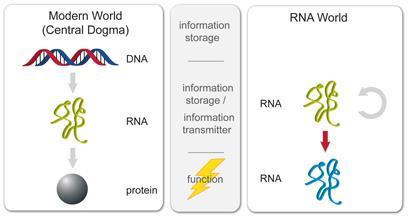

Gli sviluppi degli studi biochimici, genetico-molecolari e

cellulari hanno confermato il ruolo fondamentale del DNA come macromolecola che

registra e trasmette le informazioni specifiche, ma hanno anche mostrato che la

vita non coincide con l'informazione contenuta nelle sequenze del DNA. La

scoperta che l'RNA può svolgere funzioni catalitiche ha dimostrato che

l'informazione genetica e il codice genetico sono nati successivamente nel mondo

vivente, ossia costituiscono un modo “trovato” per riprodurre più efficacemente

l'organizzazione biologica. Prima che il DNA diventasse la molecola che porta

l'informazione genetica esisteva il mondo dell'RNA, che racchiudeva in sé

entrambe le funzioni, di memoria e di catalizzatore di reazioni chimiche, che

successivamente si sarebbero separate.

Gli acidi nucleici, d’altra parte, non devono le loro

proprietà genetiche al fatto di essere polimeri o di potersi duplicare, bensì

alla trama di relazioni tra le loro proprietà e determinate funzioni

intracellulari che consente la riproduzione di queste funzioni. Anche per

quanto riguarda i geni, è entrata progressivamente in crisi la visione

tradizionale, che associava univocamente un gene a una data sequenza

nucleotidica e quindi a una data funzione: molti geni ritenuti essenziali

possono essere inattivati senza conseguenze, mentre per altri è possibile

trovare nuove funzioni. Ciò non significa che il DNA conti poco, ma soltanto

che il suo ruolo va compreso in un contesto evolutivo e funzionale.

Una visione alternativa, congeniale ad un approccio

termodinamico e sistemico sottolinea la necessità della presenza dei principali

fattori che distinguono le cellule dalle non cellule: metabolismo tramite cicli

autocatalitici di polimeri catalitici, replicazione e un involucro fisico

all'interno di una barriera chimica, come quella fornita dalla membrana

cellulare. Questo potrebbe essere definito un approccio “prima la

proto-cellula”. I vincoli chimici e le tendenze auto-organizzanti dei sistemi

chimici complessi sarebbero stati critici nel determinare

le proprietà dei primi esseri viventi. Con l'emergere delle prime entità che

potrebbero essere chiamate viventi sarebbe nata la selezione biologica o naturale, in cui la casualità gioca un ruolo molto maggiore.